I väntan på mänskliga maskiner

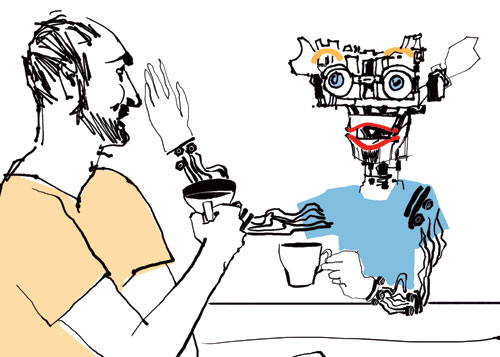

Om en maskin skulle bli intelligent, hur vet vi att den verkligen tänker? 1950 konstruerade matematikern Alan Turing det så kallade Turing-testet. Det går ut på att en människa kommunicerar med en maskin som är programmerad att agera som en människa. Om maskinen får människan att tro att den är mänsklig, har den klarat testet. Den är intelligent. Men termen artificiell intelligens myntades några år senare av John McCarthy, professor i datorvetenskap vid universitetet i Stanford, i samband med en vetenskaplig konferens.

På 60-talet trodde forskare att vi inom 20 år skulle ha maskiner som kunde utföra allt arbete en människa kan utföra. Forskningsfältet artificiell intelligens (AI) överöstes av resurser från amerikanska försvarsdepartementet och det rådde stor optimism.

Men forskarna stötte snart på problem. Det stod klart att flera av de uppgifter som kombinerade människohjärna/människokropp kan utföra är extremt komplexa. AI-forskningen levde inte upp till de tidiga förväntningarna och fältet tappade sin lyster. Flera uppfinningar som finns på marknaden i dag, som röstigenkänningssystem och schack-datorer, skulle räknas som artificiell intelligens enligt tidigare definition. Men begreppet hade fått en sådan negativ klang att de som utvecklade smart mjukvara hellre använde ord som »mönsterigenkänning«, »språkigenkänning« eller »maskininlärning«.

I dag är artificiell intelligens åter en magnet för talang och forskningspengar. System som kan kombinera allt fler intelligenta komponenter är nu på väg ut på marknaden. Dagens viktigaste genombrott sker inom datorinlärning: maskiner som kan tolka sin omgivning och dra egna slutsatser, system som kan lära sig själva. Användningsområdena är många, inom så skilda områden som dataspel, medicin, börshandel och industri.

En grupp från det amerikanska universitet Stanfords Artificial Intelligence Lab, har byggt en fjärrstyrd helikopter som lär sig flyga genom att studera andra helikoptrar. Det går till så att en skicklig pilot utför en manöver ett antal gånger med en helikopter. Med hjälp av inlärnings-algoritmer »studerar« den andra, förarlösa helikoptern, rörelserna och räknar ut det ultimata sättet att slå en volt.

– Vår dator simulerar två sekunder in i framtiden så att vi kan kompensera för vindpustar och andra situationer som kan uppstå, säger Pieter Abbeel, professor på University of California, Berkeley, som arbetar med projektet på Stanford.

– En av svårigheterna var att definiera en helikoptermanöver. En helikopter förstår inte vad »slå en volt« betyder. Vi måste bena ut vad det innebär att slå en volt: hur helikoptern står, roterar framåt och så vidare.

Det krävs en tränad pilot för att kunna utföra uppdrag med en radiostyrd helikopter. Med den nya intelligenta helikoptern krävs bara ett kommando. Bland potentiella användningsområden ser Abbeel kartläggning av skogsbränder och landminor, och som rörlig plattform för kameror som inspekterar otillgängliga platser.

Ett annat exempel på arbete inom fältet, som befinner sig ett steg närmare marknaden, är företaget Netrics. De försöker bygga ett system som på ett intelligent sätt kan bringa ordning i USA:s hälsodatabas. Ett av problemen med sjukvårdssystemet är en massiv byråkrati. För att det nu delvis digitaliserade systemet ska kunna bli effektivt och användbart för läkare och akutmottagningar måste alla system kopplas ihop och informationen om patienter i de olika systemen integreras.

Systemet Netrics är uppbyggt kring maskininlärning och utmaningen är att få systemet att lista ut »vad en människa som för hand administrerar medicinsk information skulle ha gjort«.

På Google, som står för 75 procent av alla internetsökningar, har artificiell intelligens varit målet redan från start. Grundarna Larry Page och Sergey Brin har sagt att de vill bygga en Hal 9000, en variant på den allvetande, ofelbara datorn som tar hand om rymdskeppet och astronauterna i Stanley Kubricks »2001: Ett rymdäventyr«. Page och Brin vill skapa en sökmotor som kan ge ett vettigt svar på i det närmaste vilka frågor som helst. I höstas lät de tio av sina forskare publicera artiklar om hur internet kommer utvecklas under de närmaste tio åren. Chefsingenjör Alfred Spector och forskaren Franz Och spekulerar i sökmotorns framtid. De skriver så här:

»De (datorsystemen) kommer bli smartare, gradvis förstå relationer mellan objekt, nyanser, intentioner, mening och annan djup konceptuell information.«

Google ser sin framtida skepnad som ett intelligent moln som förstår vad individen sannolikt menar med konceptuella förfrågningar. Ett steg i den riktningen är Googles Audio Indexing, en tjänst som söker på talade ord i framför allt politiska tal.

Inom AI-fältet pratar man om »ren« eller »stark« artificiell intelligens, vilket innebär att skapa ett system som kan processa information lika effektivt som en människa. Dit är det ännu långt. Vad Google försöker skapa är inte mänsklig intelligens. Bolaget vill förbättra sitt systems inlärningsförmåga och slipa sina relevans-algoritmer.

Men vissa hävdar att en fullt utvecklad AI är en omöjlighet. Kritikerna menar dels att människan aldrig helt kan förstå sitt eget beteende och därmed inte kan studera vårt eget sammanhang utifrån. En annan invändning är att den mänskliga tanken fungerar enligt kvantfysikaliska principer, som inte går att härma med matematiska algoritmer. Men John McCarthy, som i dag är 81 år, har inte gett upp.

– Intelligens har olika komponenter, några av dem har vi redan skapat på artificiell väg, andra inte. Tyvärr vet jag inte när vi kommer att ha en maskin vars intelligens ligger på samma nivå som en människas. Det kräver nya idéer, säger han.

Med rötterna inom flera vetenskaper

AI är en vetenskap som strävar efter att förstå och även bygga intelligenta system. Exakt vad begreppet omfattar råder det delade meningar om. Datavetarna Stuart Russell och Peter Norvig presenterar de olika perspektiven inom kunskapsområdet genom att ordna dem utifrån de två dimensionerna tankeprocesser och beteende, där fyra alternativa målsättningar följer utifrån vilka man kan försöka att skapa intelligenta system.

De fyra alternativen är: system som tänker som människor, system som tänker rationellt, system som beter sig som människor, och slutligen system som beter sig rationellt.

AI har sina rötter inom ett flertal olika vetenskaper som alla har bidragit med idéer och metoder. Filosofin har bidragit med teorier om resonerande och lärande, matematiken med formella teorier om logik, sannolikhet, beslutstagande och beräkningsbarhet; psykologin med verktyg för att undersöka den mänskliga hjärnan; lingvistiken med teorier om struktur och innebörd av språk; och slutligen datavetenskapen med verktyg lämpade att skapa AI.

Termen artificiell intelligens myntades av John McCarthy, professor i datorvetenskap vid universitetet i Stanford. Sommaren 1955 ansökte McCarthy om pengar för en konferens om de saker som intresserade honom. Han behövde ett namn och döpte sin konferens till »The Dartmouth Summer Workshop on Artificial Intelligence«. Flera av konferensens deltagare kom senare att bli nyckelfigurer inom AI. John McCarthy, Marvin Minsky, Allen Newell och Herbert Simon grundade AI-laboratorier vid Massachusetts Institute of Technology (MIT) i Boston, Carnegie Mellon i Pittsburgh och Stanford i San Francisco. Deras system löste logiska problem och pratade engelska. McCarthy uppfann Lisp, som blev AI-forskningens huvudsakliga programmeringsspråk.